论文阅读-Pixel-Wise Recognition for Holistic Surgical Scene Understanding

2025-01-20发布于论文随笔 | 最后更新于2025-01-20 21:01:00

Arxiv原文链接:Pixel-Wise Recognition for Holistic Surgical Scene Understanding

投稿于MEDIA(Medical Image Analysis)

基本介绍

本篇文章的工作较为庞大,收集了超过32小时的前列腺手术视频构成了一个新的数据集GraSP(Holistic and Multi-Granular Surgical Scene Understanding of Prostatectomies),并且提出了一个通用于所有相关识别任务的模型架构TAPIS(Transformers for Actions, Phases, Steps and Instrument Segmentation)。

GraSP

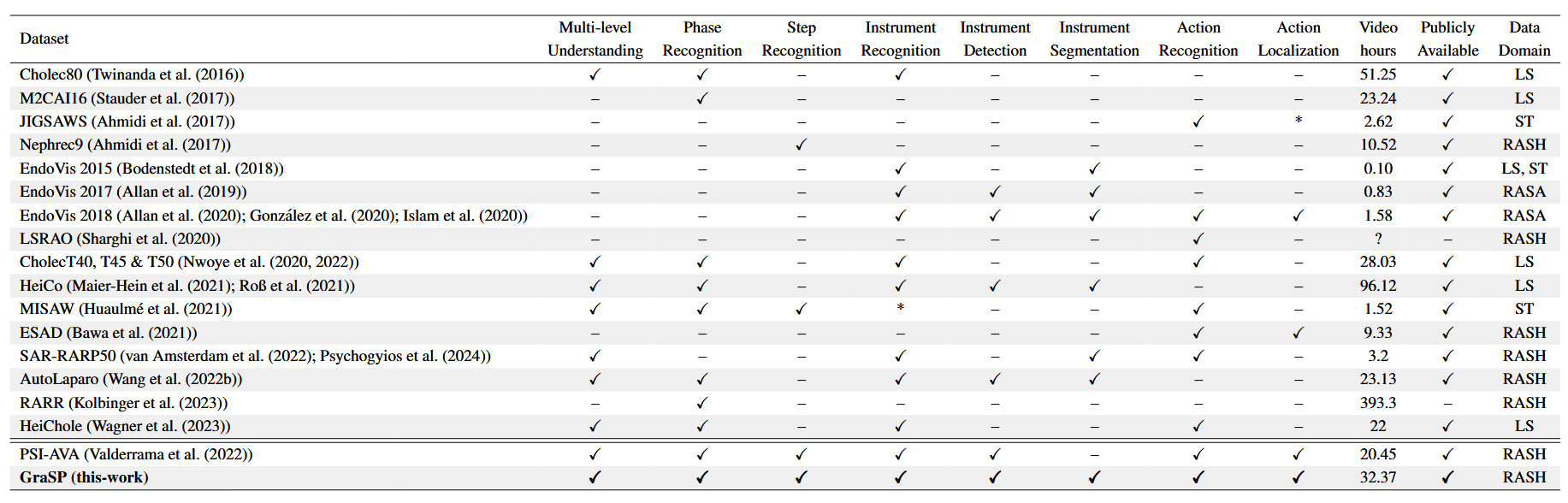

常用内窥镜手术视频数据集对比如下表,其中LS表示传统腹腔镜手术(Laparoscopic Surgery)、ST表示离体手术训练(ex vivo Surgical Training Procedures)、RASA表示动物机器人辅助手术(Robot-Asissted Surgery on Animal object)、RASH表示人类机器人辅助手术(Robot-Asissted Surgery on Human object)

由于该数据集标注丰富,所有相关的识别任务都可以在上面做,包括手术工作流分析、手术器械分割、手术动作识别、手术场景理解等。因此,本文也对识别的类型做了一定的分层,下面的分层图中过弱的连接关系已被移除。

由多位专业医生完成标注工作,对于有冲突的标注,会进一步讨论确认。

TAPIS

模型整体结构如下图所示,可以看到将任务分为了长期和短期两种类别。有如下几个关键点

- 在关键帧上使用独立的器械分割baseline,以此为RPN(Region Proposal Network),提供了本地像素级的器械掩码以及分割区域的对应embedding

- 在以关键帧为中心的视频片段上使用了一个全局的视频特征提取器,以提供类别embedding与时空embedding序列

- 帧分类头使用类别embedding对关键帧进行分类,完成手术阶段和手术步的分类

- 区域分类头结合了本地区域embedding与全局时空特征完成原子动作预测与器械区域分类

器械分割

instrument segment部分使用MATIS与Mask2Former作为主要分割baseline和region proposal方法。简单来说,使用一个transformer decoder,将一组可学习的目标query应用于backbone提取的特征,以此获得各分割部分的embedding。

视频特征提取

使用MViT(Multiscale Vision Transformers)作为视频特征提取器。简单来说,MViT会将图片分为相互重叠的patch,再不断将时空维度换入通道维度。本文将以关键帧为中心帧的整个窗口放入MViT,利用MViT自行计算的class token对帧进行分类,实现手术阶段和手术步这两个长期识别任务。

区域分类

本文使用交叉注意力将区域信息和时空特征结合,会将各分割区域的embedding作为query,时空特征作为key和value,最后使用线性层将区域特征投影到器械和原子动作类别

实验结果

下表展示了TAPIS在GraSP上的表现,其中的参数量和FLOPS都不算RPN的,TAPIR是本篇文章区域分类使用的基础网络,VST指的是Video Swin Transformer:

下表展示了RDV于RiT这两个常用模型在GraSP上与TAPIS的性能对比:

下面的几张表则对比了TAPIS在其他常用数据集上与其他模型的性能对比:

另外,GraSP数据集也设计了两个Fold用以交叉验证,下表展示了交叉验证时在手术阶段与手术步骤上的性能对比: